AI 产业界动态不断,学术界也没闲着。

这几天,各个 AI 顶会出分的出分,开会的开会,造梗的造梗——尤其是 NeurIPS,贵为机器学习领域三大顶会之一,它的评审意见是近期 AI 学术圈最大的笑料。

“Who’s Adam?“当这条审稿意见出现在一位作者的论文中,立刻引起学术圈一片哗然。

Adam 是深度学习中最常见的优化方法之一,论文被引用超20万次。

AI 顶会的审稿人在评审中不识 Adam,的确,非常离谱。

* 审稿人:"「Adam」 是啥?我认为这是一个非常严重的拼写错误,作者本应在投稿前删除。"

更多的吐槽是审稿人不认真,用 GPT 审稿。

在 X 上,有人发帖称自己的审稿意见上,甚至被审稿员留下了 GPT Prompt…

*德克萨斯农工大学计算机系任助理教授 Zhengzhong Tu 的帖子

我们身边的朋友也遭遇了GPT 审稿。

“真人审稿的意见有好有坏,但审稿人用 AI,可能会恶意 prompt GPT 只写批评的意见。还有些 AI 会出现幻觉,说一些和你论文无关的点评。“一位作者说,他看到不合理意见后,拿 GPTZero 做了检测,证实了自己的猜想。

7月24日-7月30日,是今年 NeurIPS 的 rebuttal (反驳)时间。整整一周,他都在和 GPT 的审稿结果 rebuttal。

8月6日,是最后一天审稿人和作者互相交流(掰头)的时间。之后,作者们只能在9月出分时看到自己论文的最终结果。

也就是说,明天过后,会有一批学术圈的朋友只能在愤怒中结束自己的 NeurIPS 2025。

AI审稿,愈演愈烈的三年

这些由 AI 给出的离谱审稿意见,已经持续出现很久。

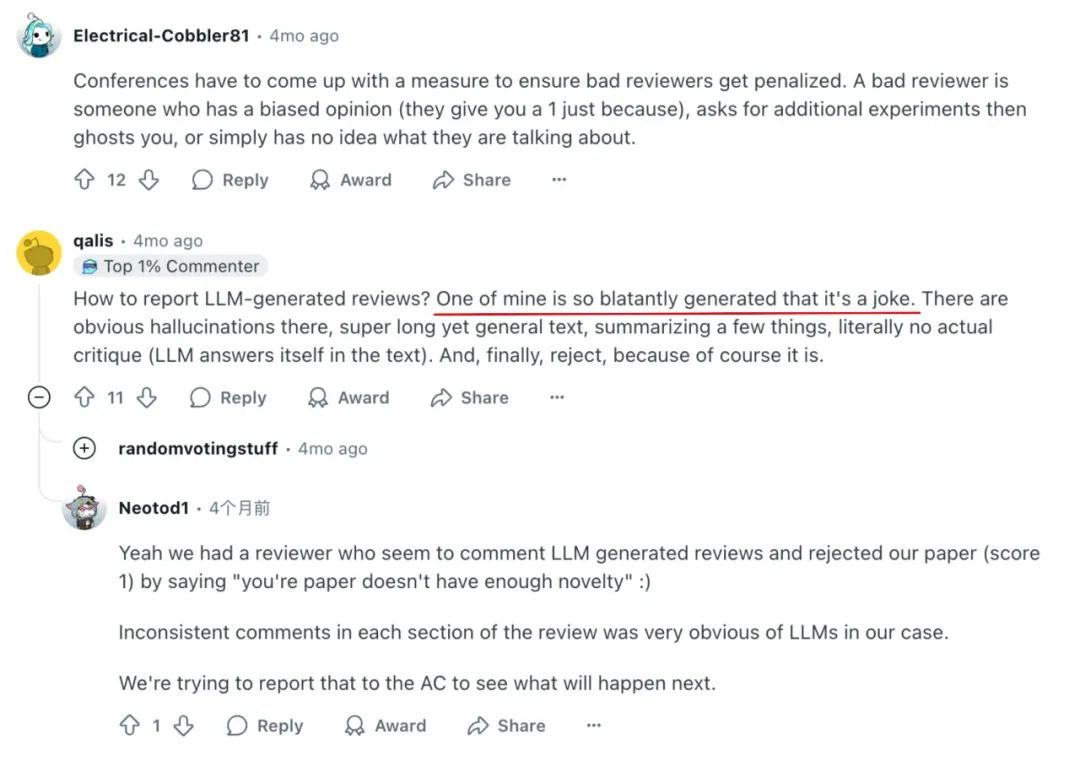

四个月前,当另一顶会 ICML 出结果时,就有很多作者吐槽自己收到了空洞又充斥着 AI 幻觉的审稿意见。

* 投递了ICML的作者吐槽,他收到的一份评审意见明目张胆地由AI生成,简直是个笑话

这次闹出"Adam"大笑话的 NeurIPS 更是惯犯。2024年,它就因为 AI 审稿伤过作者们的心。

当时,有同时承担审核角色的论文作者在 Reddit 上评论,他花费了一个月时间审核了6篇论文,但自己的论文却只得到了 LLM 评价,真的很受伤。

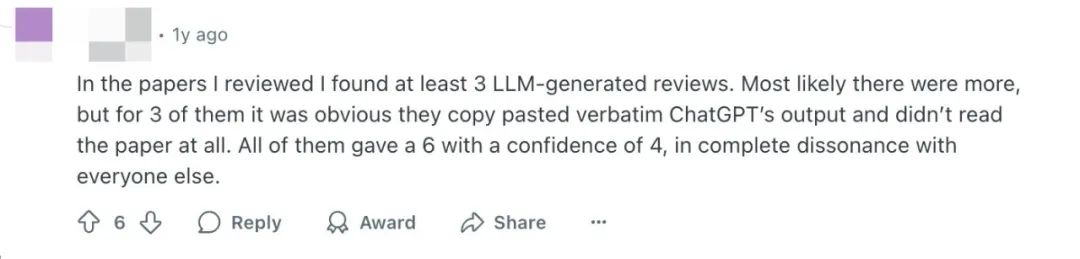

同样在 NeurIPS 2024,有审稿人表示,在自己审阅的论文中,至少发现了3篇由大模型生成的评审意见。为什么只说这3篇,因为它们明显直接复制粘贴了 ChatGPT 输出,完全没有阅读论文。

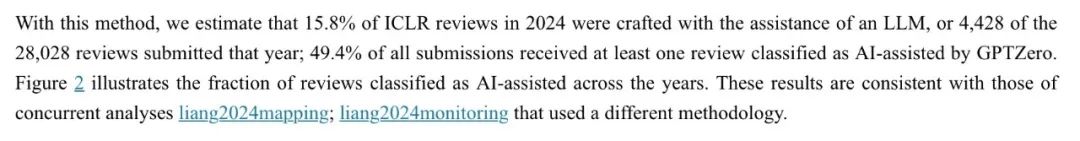

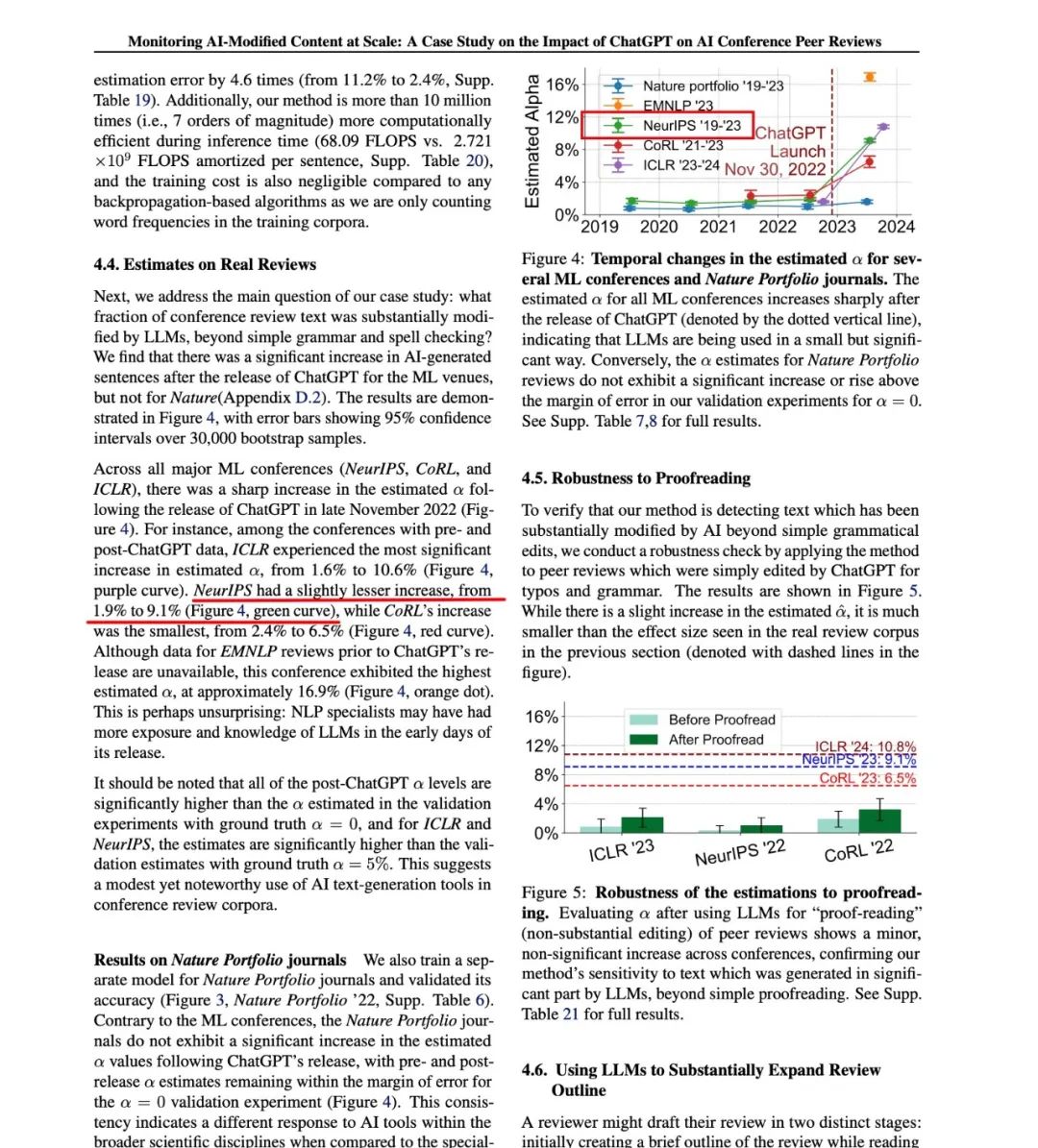

一项针对顶会 ICLR 2024 的研究发现,高达15.8%的评审意见包含了大量 AI 生成的内容。有近一半的提交论文,至少收到了一份被 AI 检测工具 GPTZero 标记的审核意见。

*https://arxiv.org/html/2405.02150v1

AI 审稿的痕迹还能追溯到2023年。

一项针对 NeurIPS 2023 的研究表示,当时有9.1%的评审意见可能是在 AI 辅助下完成的。

*https://arxiv.org/pdf/2403.07183

UC 伯克利的博士后 Xuandong Zhao 的发言可能是很多人的心声:

“两年前,大概有十分之一的评审感觉是 AI 辅助写的。现在呢?似乎十之有九的评审都是经过 AI 修改的,不仅包括语法修正,还包括完全生成的评论。”

全世界都在卷论文,审稿人不够用了

论文实在太多了。

这很可能是这些审稿人,明明最知道 AI 不靠谱,还要偷偷用 AI 审稿的根本原因。

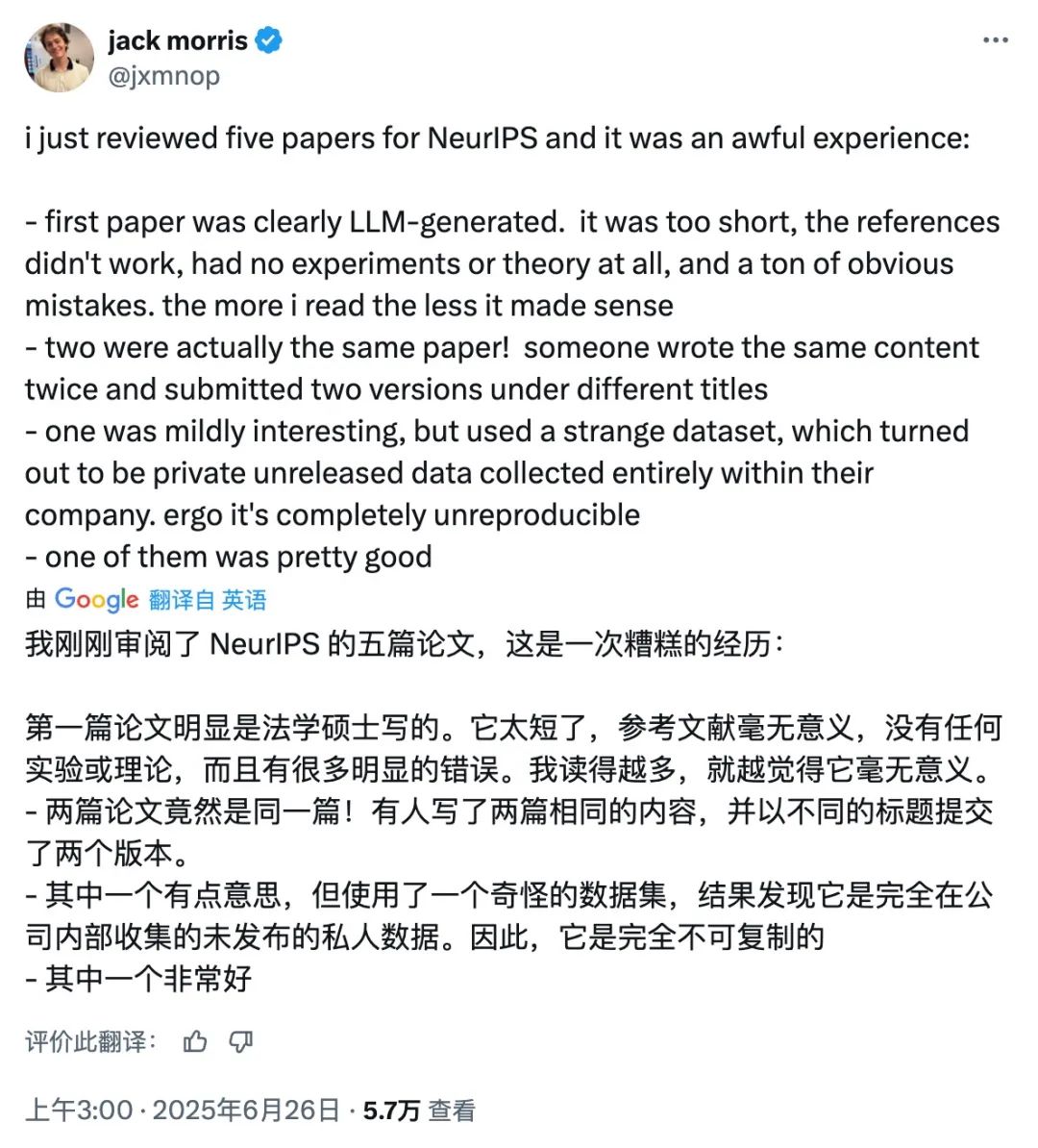

一位审稿人最近在 X 上爆料称,自己连着审了5篇论文,体验简直糟糕透顶。

他发现,有一篇论文明显是用 AI 写的,文章很短且毫无意义。但这样的文章却还有另外一篇内容完全相同的“双胞胎”——它们是同一个作者,用两个不同的标题分别提交的。

有了 AI 工具又乘上行业的东风,统计显示,这几年各个 AI 学术会议的论文提交量都在狂飙。

先说 NeurIPS。今年 NeurIPS 有30000多篇投稿,达到历史巅峰。而上一次的巅峰,就是2024年的15000多篇。

前几天刚落下帷幕的 ACL,今年总投稿数同样创下历史新高,达到8360篇。去年,这个数字是4407。

也就是说,一年内多个顶会的投稿量几乎涨了100%……

一些人认为,导致 AI 论文数量飙升的一大原因,是很多硕士生和博士生期待通过顶会被大厂丰厚的人才招揽计划看到。

按这个逻辑,只要 AI 热潮一直持续,论文数量就不会少。

面对逐年狂增的论文数量,学术会议官方明显压力山大。

NeurIPS 官方在其“负责任评审倡议”的博客中坦承:“随着 NeurIPS 规模的扩大,维持评审质量变得越来越困难。”

为了审完这些稿件,NeurIPS 组委会需要招募非常多的审稿人。今年2月,NeurIPS 官网还没建好,已经有人收到了大会的审稿邀请邮件。而2024年,审稿人的邀请从5月开始。

矛盾之处在于,**有能力和意愿进行高质量评审的专家经常忙于自己的研究。**最终参与评审的审稿人,并不一定具备合格的审稿水平。

而且今年 NeurIPS 还放了狠招,要求参与审稿的研究员必须在截止日期前审完,否则他们自己的论文就会直接被拒掉。

这就导致,一些本来就在"用爱发电"的审稿人为保证自己的论文不被拒,开始急匆匆地用 AI “水"审稿。

事实上,现在各大学术会议对使用 AI 评审,还没有完全一致的规定。有些会议说审稿人可以在不重要的工作环节尝试 AI,有些则没有明确说明。

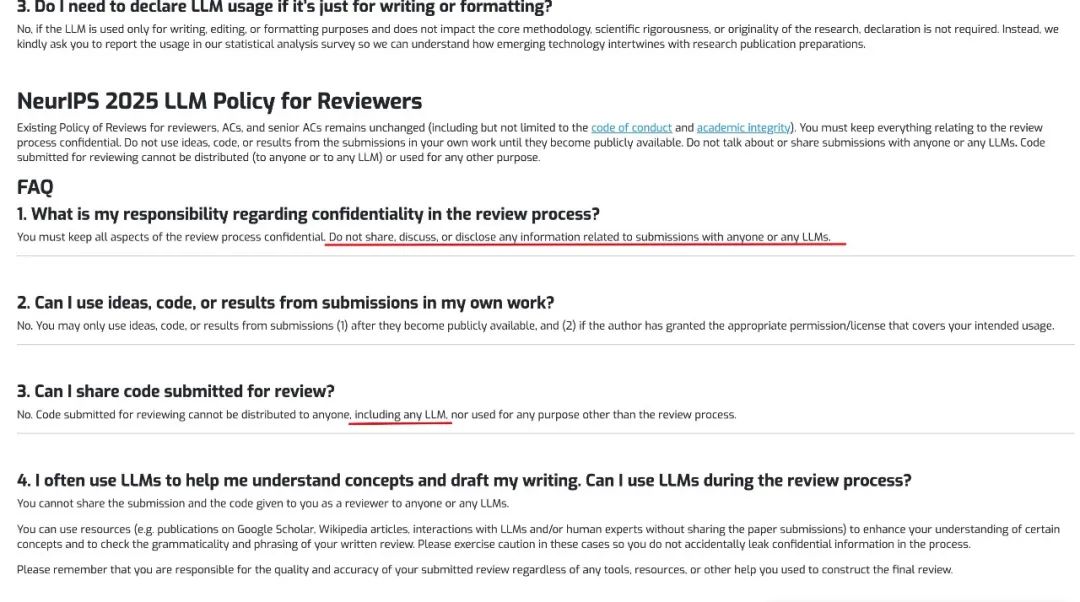

相比之下,NeurIPS 的要求较为清晰——出于保密和尊重,它明令禁止审稿人和任何 LLM 讨论、分享论文信息。审稿人仅被允许使用 LLM 进行背景研究或校对语言(例如查阅别人发的资料,不包括稿件本身)。

但是,这些直接出现在论文中的 Prompt 痕迹证明,很多审稿人已经直接把自己要看的文章丢给了 GPT 们。

*NeurlPS 的相关规定

目前在各个学术会议中,在审稿机制上较为创新的是 RLC。这家2024年才出现的、专注于强化学习的新会,提出了新的审稿流程。

与 NeurIPS/ICLR/ICML 的流程不同,RLC 在2024年做出了以下要求:

-

优先保证论文的技术正确性。

-

评审意见“重质不重量”;专注于少量的高质量评论;论文作者都会收到详细反馈。

-

审稿人不负责判断某种方法的新颖性或影响力,因为学术社区会自发“用参考文献投票”。他们只需判断研究的技术正确性,这会大大减轻审稿人的负担,让他们提供更全面的评审意见。

-

每篇论文的评审都由高年级博士生和高级审稿人配对组成,前者关注技术正确性,后者复核评审意见并提供更高层次的视角;同时,博士生还能获得审稿方面的指导和成长。

这几个设置,能减少现在不少 AI 顶会审稿人负担过重、各评审标准不一致、评审意见过于粗糙等问题。

但不能忽视,RLC 之所以能设置这类机制,还是因为体量没有其他顶会庞大。2025年,它的投稿量只有280篇左右。

对 NeurIPS/ICLR/ICML 这些稿件达到数万篇的会议来说,如何在庞大的工作量中保证评审质量,可能会是长期的难题。

参考:

https://mp.weixin.qq.com/s/a6Na6WGod5bjGktFMXp8rw

https://neurips.cc/Conferences/2025/LLM

https://finance.sina.cn/stock/jdts/2025-07-27/detail-infhxkpt6519493.d.html